Trombei esses dias com um artigo de 2001 sobre propagação de vírus em humanos e sua comparação a vírus de internet. O estudo da disseminação de infecções é velho na física, diversos modelos de epidemias são estudados e muitos com resultados razoavelmente bons. Um ponto comum em modelos estudados pela epidemiologia é a noção de threshold, ou seja, o valor mínimo de eficiência que uma infecção deve ter para conseguir se propagar. Novamente, esse é um post hardcore, os corajosos sigam-me, vamos ver com cuidado como isso funciona.

Esse post ficou grande, então parti em dois. Nesse primeiro, comento o modelo de propagação de vírus em seres humanos, no próximo trato da internet.

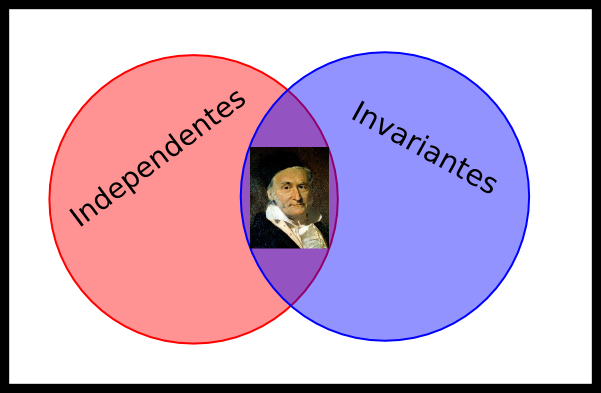

Representamos indivíduos como pontos e o contato entre indivíduos como linhas em um grande grafo. Passamos a nos perguntar qual seria um modelo eficaz de grafo para modelizar as relações humanas. Certamente não conhecemos pessoas aleatoriamente na rua, costumamos conhecer melhor nossos vizinhos, familiares e colegas de trabalho, que por sua vez conhecem-se. Um jeito legal de modelizar essa ideia, que chamamos de grafo de small world, é tomar um anel de pontos, sendo cada ponto ligado a seus $ m$ vizinhos mais próximos. Em seguida, passamos “em revista” essas conexões da seguinte forma: cada ponto terá uma probabilidade $ p$ de desfazer uma conexão com um vizinho seu no sentido horário e associá-la a algum outro ponto aleatoriamente. A ideia do sentido horário é apenas para evitar mexer na mesma conexão duas vezes. Se $ p=1$, essa revista resulta em um grafo em forma de anel com conexões completamente aleatórias. Se $ p=0$, o grafo continuará no modelo do conhecimento apenas da vizinhança, mas, se $ p$ é pequeno, o grafo tornar-se-á um modelo muito próximo do que queremos: vizinhos possuem uma chance maior de se conhecerem do que conhecerem alguém do outro lado do grafo, mas de vez em quando algum vizinho seu conhece alguém lá longe, o que é bem coerente com a realidade e até permite aquelas coincidências do tipo “hoje meu avô almoçou com o pai de um professor meu”.

O resultado está bem representado nessa figura, onde os pontos são inicialmente ligados a seus $ 2m$ vizinhos mais próximos, com $ m=2$. É o famoso modelo de Watts-Strogatz, ou modelo de small-world:

Podemos, com esse modelo bonitinho, estudar a propagação de infecções entre seres humanos. Imaginemos um vírus que, a cada contato entre são e infectado, tenha uma probabilidade $ nu$ de contágio e, a cada “turno”, tenha uma probabilidade $ \delta$ de cura de um infectado. A chance de um ponto possuir $ k$ vínculos é $ P(k)= \frac{1}{\langle k\rangle}e^{-k/\langle k\rangle}$ nesse modelo, e $ \langle k\rangle=2m$. A equação estocástica dessa criança não é bonita, então vamos usar um mean field, calcular o que vai acontecer com a densidade média de infectados supondo que todos os pontos possuem o mesmo número de conexões, $ 2m$, naturalmente, e que todos estão ligados a um número de infectados igual ao valor médio de infectados, essas são as características de uma abordagem de campo médio. A densidade total de infectados, denotada $ \rho_t$ por ser uma função do tempo, é apenas o número total de infectados dividido pelo número total de pessoas. Diremos que a variação na densidade de infectados $ \rho_t$ (a fração da população infectada naquela “rodada”), que toma valores entre 0 e 1, perde a cada “rodada” o equivalente a $ \delta\rho_t$ (os que se curaram) e ganha o equivalente ao contato são-infectado, que é $ nu\langle k\rangle\rho_t(1-\rho_t)$, ou seja, chance de um contato ser são-infectado $ \rho_t(1-\rho_t)$ multiplicada pelo número médio de contatos $ \langle k\rangle$ e pela chance de esse contato transmitir a infecção $ \nu$. Dividindo a equação toda por $ \delta$ e sem precisar ir muito além de uma reparametrização no tempo, podemos escrever:

\[\frac{d}{dt}\rho_t=-\rho_t+\lambda\langle k\rangle\rho_t(1-\rho_t).\]

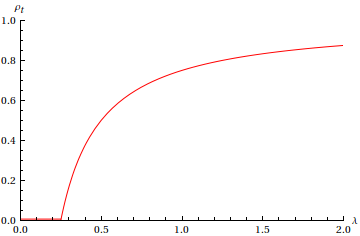

Com $ \lambda= \frac{\nu}{\delta}$ o valor que interessa para medir a eficácia de uma infecção. E essa equação, ainda que seja apenas uma teoria de campo médio, já nos dá bastante informação sobre o que está acontecendo. Você até pode pedir para o Wolfram Alpha resolver essa para você, eu não faria diferente, mas vale mais estudar algumas propriedades na mão. Chamamos densidade de persistência o valor de $ rho_t$ para o qual sua derivada temporal é zero. Se ela não é nula, temos uma infecção persistente em uma fração da população. Igualando a equação acima a zero, percebemos duas respostas possíveis: ou $ rho_t = 0$, ou $ \rho_t=1- \frac{1}{\lambda\langle k\rangle}$. Como a densidade de infectados não pode ser menor que 0, naturalmente, descobrimos que, se $ \lambda < \frac{1}{\langle k\rangle}$, então a única solução possível é $ \rho_t=0$, pois a segunda solução fica absurda. Mas, se a infecção é mais eficaz que o threshold $ \frac{1}{\langle k\rangle}$, teremos um crescimento da densidade de persistência que tende a 1 quando $ \lambda$ se aproxima do infinito.

E fica claro que o threshold, dependendo do inverso do número médio de contatos, que nesse modelo é proporcional ao número de vizinhos, nos dá uma informação esperada: quanto maior o número de vizinhos (contatos), menos eficaz uma doença deve ser para se propagar. Se uma doença é bem eficaz, podemos reduzir seu impacto com uma diminuição nos vizinhos, se está com gripe, não saia de casa.

Esse modelo é bem coerente com diversas observações de epidemias simples em populações. Por esse mecanismo de small-world, apenas doenças suficientemente poderosas, com eficácia $ \lambda$ maior que um determinado limite, podem se propagar pela população, possuem vida no longo prazo. A mudança de fase ocorre no threshold $ \lambda^\star= \frac{1}{\langle k\rangle}$ que, no gráfico acima, ocorre em $ \lambda = 0,25$. O próximo passo nesse modelo seria estudar um grafo em que pessoas podem morrer, nascer, tornar-se imunes, tomarem vacinas ou tornarem-se mais suscetíveis a doenças com o tempo.

Tudo isso é muito interessante, mas não consegue explicar a propagação de vírus na internet. Em um próximo post, veremos que, na internet, small-world não pode ser aplicado (afinal, todos conhecem o Google ou o Facebook) e a própria noção de threshold, por um fenômeno estatístico fascinante, desaparece.